Introduction

伴随着深度神经网络技术的发展,Re-ID任务得到了很好的发展,然而Re-ID从深度神经网络里得到不仅仅是提升,也继承了深度神经网络中脆弱性。近年来针对深度神经网络的对抗性攻击取得了不错的成果,在图像分类等人物中,已经有很好的方案去欺诈分类器。本文希望通过对抗性攻击完成对基于DNN的Re-ID模型的欺诈。

通过探索对现有Re-ID模型的对抗性攻击,可以挖掘出现有的模型的弱点,有利于对Re-ID问题的鲁棒性的提升,是一项很有意义的工作。

由于现实世界中的人物是无穷尽的,且他们不会存在于数据集中。因此,针对Re-ID问题的攻击和对于图像分类等人物的攻击是不一样的,应被视为一个跨域黑箱攻击问题。现有的对抗性攻击方法通常都不具有跨域迁移性,同时,作者期望这样的攻击是隐式的,在不影响图像的感知质量的条件下实现攻击,使人眼不能发觉图像已经过了破坏。

Methodology

Overall Framework

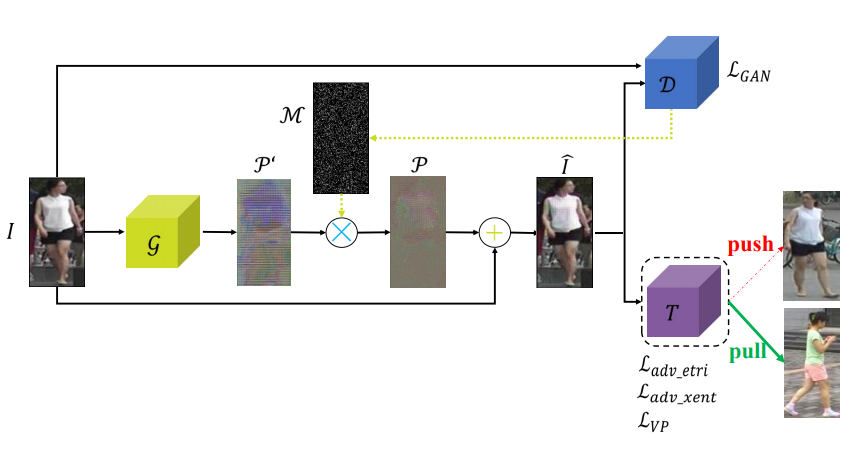

- 下图展示了网络的基本框架,网络的目标是通过生成器为每一张输入图像生成一组具有欺骗性的噪音,进而获得对抗性样本,该样本可以欺骗Re-ID系统使其输出错误的结果。

Learning-to-Mis-Rank Formulation For ReID

- 为了打乱Re-ID系统输出的排序,论文提出了一种新的误排序损失Mis-ranking Loss来攻击Re-ID系统的排序环节。该损失的形式同三元损失类似,但优化方向与三元损失相反,误排序损失希望最小化不匹配样本对之间的距离,同时最大化匹配的样本对之间的距离。该损失函数的形式如下:

- 上式中代表第个ID下的人物图像样本的数量,代表第个ID下的第张图像样本,和代表同一个ID和不同ID下的样本,代表边界阈值。

Learning Transferable Features for Attacking

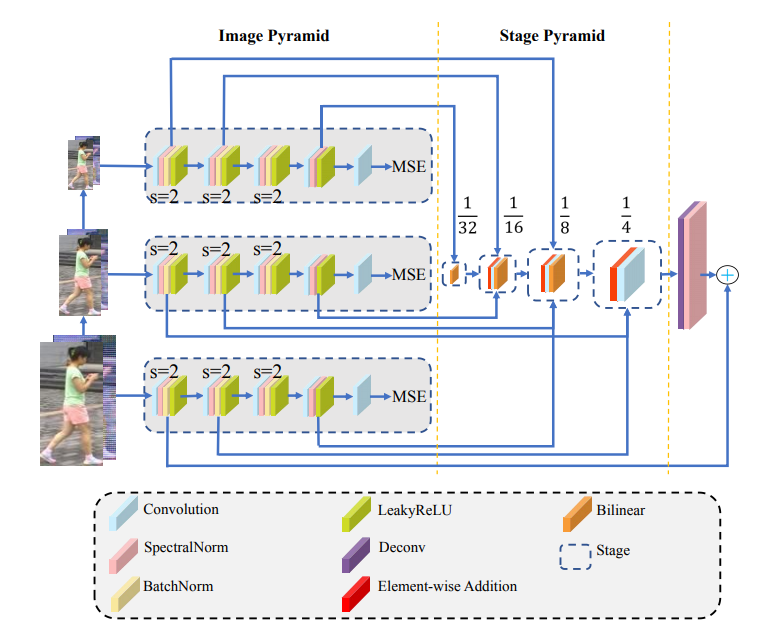

为了提升模型的迁移能力,论文作者设计了一种新型的判别器结构,配合ResNet50的生成器,组成了一个拥有更强的表征学习能力的GAN网络,用于提取通用性更强的特征来实施对抗干扰。

判别器使用了多尺度输入下的多层次特征进行融合,其网络结构如图所示

Controlling the Number of the Attacked Pixels

为了使攻击不易被感知(即,使攻击可以欺骗Re-ID系统,但不易被人类察觉),作者做了两个方面的工作,其中之一是控制被攻击的像素点的个数。

本文对判别器的Softmax输出向量通过一个基于Gumbel-Softmax的方式计算特征图上所有像素点的概率分布,掩膜选取概率最高的个像素点保留,其余在正向传播中舍弃,以此从生成器输出的初始噪声中选择出最终的噪声。

式中,是分布的软化参数。

Perception Loss for Visual Qualit

作者为了保证攻击不易察觉所做的另一个工作是引入了一个损失函数来描述所生成图像与原始图像的视觉差异。

受启发于多尺度结构相似性(Multi-Scale-Structure Similarity Index,MS-SSIM),作者提出了感知损失(Perception Loss),其具体形式如下

上式中代表方差或协方差,是各个组件的权重,代表图像的尺度级。

Objective Function

除了上文提到的误排序损失和感知损失,网络还受两个损失函数的监督,分别是误分类损失(Misclassification Loss)和GAN损失,四种损失经过加权得到总的损失。

误分类损失在形式上是一个带有标签平滑的交叉熵损失,唯一的区别在于对于标签的编码形式,常规的分类任务会将标签编码成真实类别为1其余项为0的One-hot编码,这里的编码形式是使正确类别为0,其余类别为,是总的类别数。代表log-softmax函数,是平滑因子。

GAN损失被定义为

Paper Information

Wang H, Wang G, Li Y, et al. Transferable, Controllable, and Inconspicuous Adversarial Attacks on Person Re-identification With Deep Mis-Ranking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 342-351.

Code:https://github.com/whj363636/Adversarial-attack-on-Person-ReID-With-Deep-Mis-Ranking